- 人工智能与能源:人工智能会减少排放还是增加需求?

- 发布时间:2024-08-19 11:04:51

人工智能会消耗多少能源?如果我们问问ChatGPT,它是这样说的:

“人工智能系统的能耗因其复杂性和用途而存在很大差异,但通常需要大量电力才能有效地处理和分析数据。”

据估计,ChatGPT光是回复这一句话,所需的电量即达到Google搜索的约十倍。ChatGPT每周有1亿用户,因此额外的能源需求开始累积。这还只是单个平台上的用户。

在整个人工智能行业中,不断增长的能源需求(主要来自于构建和运行用于训练和操作人工智能模型的数据中心)正在导致全球温室气体排放增加。

微软作为ChatGPT开发商OpenAI的投资者之一,将生成式人工智能工具定位为其产品的核心。该公司最近声明,由于数据中心扩张,其二氧化碳排放量自2020年以来增加了近30%。谷歌2023年的温室气体排放量则比2019年高出几乎50%,这主要是来自与数据中心相关的能源需求。

因此,虽然人工智能工具有望帮助能源转型,但它们也需要强大的计算能力来支撑。

✦ 是什么推动了人工智能的能源需求? ✦

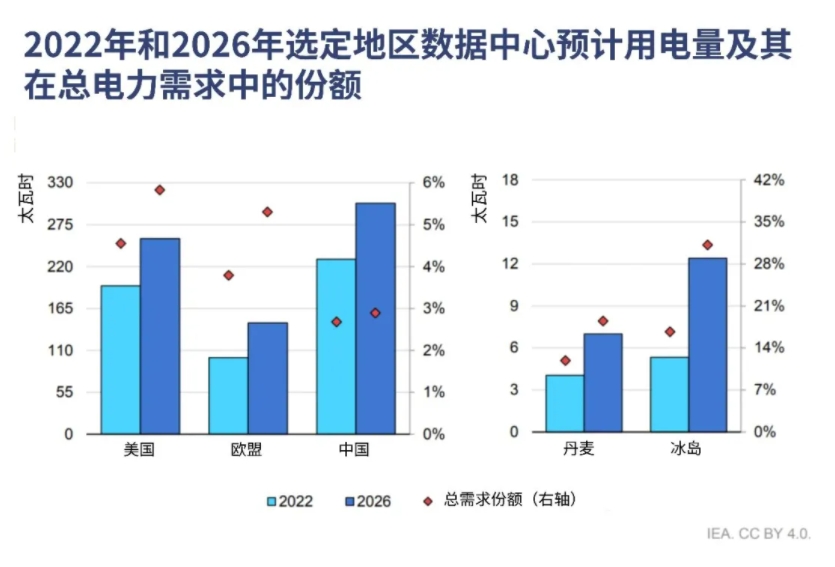

目前,人工智能的能源消耗仅占科技行业电力消耗的一小部分,估计占全球总排放量的2-3%左右。随着越来越多的企业、政府和组织使用人工智能来提高效率和生产力,这种情况可能会有所改变。如下图所示,数据中心已经成为许多地区电力需求增长的重要驱动力。

全球数据中心的电力消耗。图片来源:国际能源署

人工智能需要大量计算能力,而生成式人工智能系统完成一项任务所需的能量,可能已经是专门针对某一任务的软件的33倍。

随着人工智能的普及并进一步发展,训练和运行这些模型将推动全球数据中心数量及相关能源消耗的指数级增长。这将给本已紧张的电网带来越来越大的压力。

生成式人工智能模型训练的耗能尤其高,比传统数据中心活动消耗的电量要多得多。正如一位人工智能研究人员所说:“人工智能模型到了部署阶段时,更是必须始终保持开机状态。ChatGPT就从来不会关机。”

像构建ChatGPT所用的大型语言模型,其复杂程度正不断增长,也侧面印证了人工智能对能源的需求正不断增加。

据估计,训练一个像GPT-3这样的模型将耗费近1300兆瓦时(MWh)的电力。这大致相当于美国130户家庭一年的用电量。

而训练更先进的GPT-4,其耗电量估计是GPT-3的50倍。

总体而言,维持人工智能增长所需的计算能力大约每100天翻一番。

✦ 如何优化人工智能行业的能源利用效率? ✦

社会需探索难题,探讨人工智能经济社会效益是否胜过环境代价。具体言,人工智能对能源改革益处是否胜过耗能增加?

找到挑战和机遇之间的最佳平衡点将是关键。

根据预测,到2030年,人工智能或将有可能减少全球温室气体排放量5-10%。那么,如何实现这一减排目标呢?

监管机构,如欧洲议会,开始提出规定,要求人工智能系统能够记录能源使用情况。技术的不断进步或有助于解决人工智能的能源消耗问题,更先进的硬件和处理能力有望提升人工智能工作效率。

科研专家目前致力于开发定制硬件,如创新的加速器和性能显著提升的3D芯片,以及先进的芯片冷却技术。Nvidia声称,他们的全新“超强芯片”在执行生成式人工智能服务时,能够实现性能提升30倍,同时能源消耗减少25倍。

随着时间推移,数据中心的效率不断提升。为了更有效地运作,人们正在研究创新的冷却技术,优先选择在电力成本更低、供应更充足、更可持续的地点进行更多计算。

此外,关键之处在于降低整体数据使用量,解决暗数据问题,即生成但未再次使用过的数据。同时采用资源需求较少的小型语言模型,对特定任务将有助。寻找性能、成本、人工智能工作负载的碳足迹之间更佳平衡至关重要。

✦ 人工智能对电网的影响如何? ✦

电网受压情况并非全因人工智能,人口增长和能源需求上升也是影响电网减碳速度的因素。

返回列表

返回列表